医药器械法规AI项目

服务器

cdh服务器

主机: 192.168.8.67

端口: 22

用户: root

密码: zhiyun

当前服务器平台版本:CDH6.3

http://192.168.8.67:7180/cmf/login 用户密码都是 admin

1 | # 创建个人目录 |

数据库

主机:192.168.8.8

数据库:jd

密码:123456

配置文件编写

1 | { |

抽取数据

1 | # 注意抽取前需要提前创建HDFS目录 |

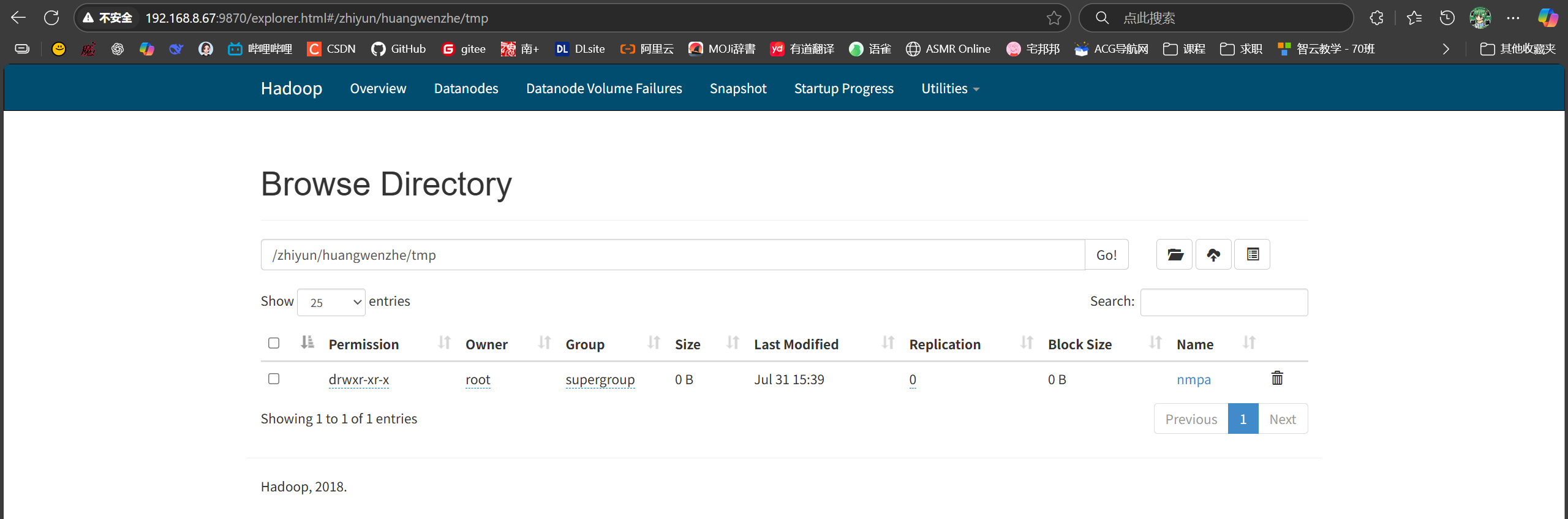

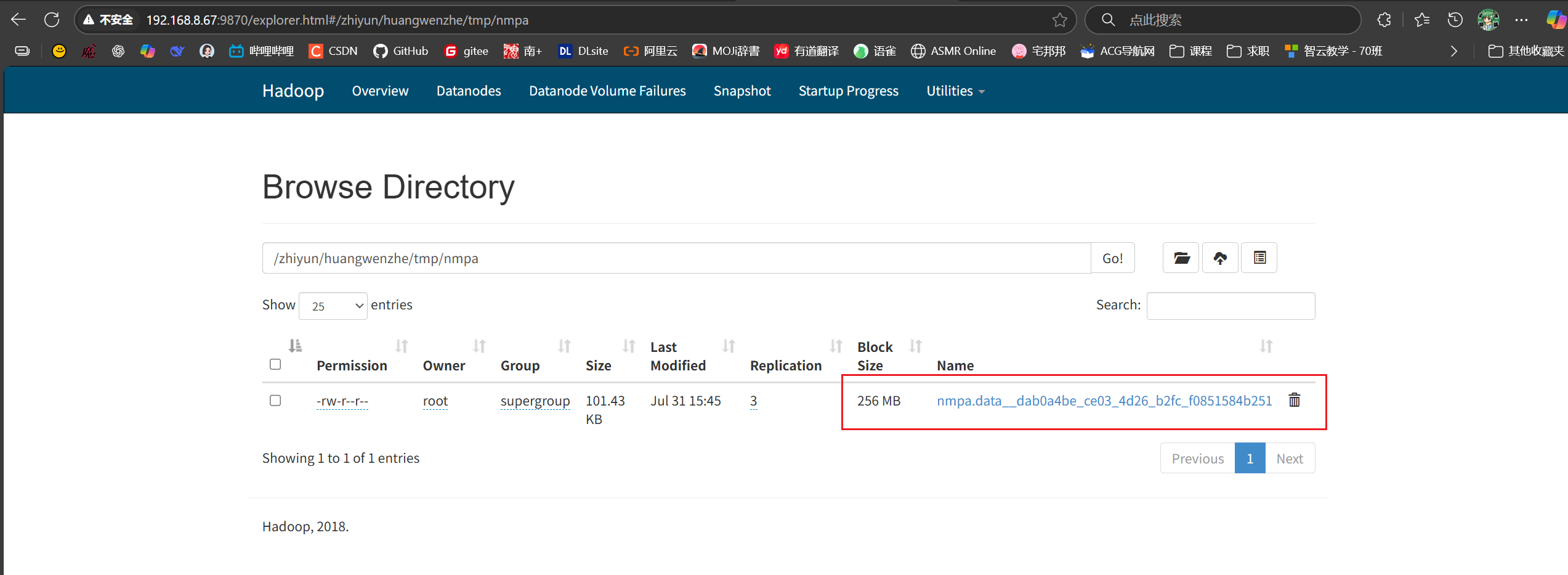

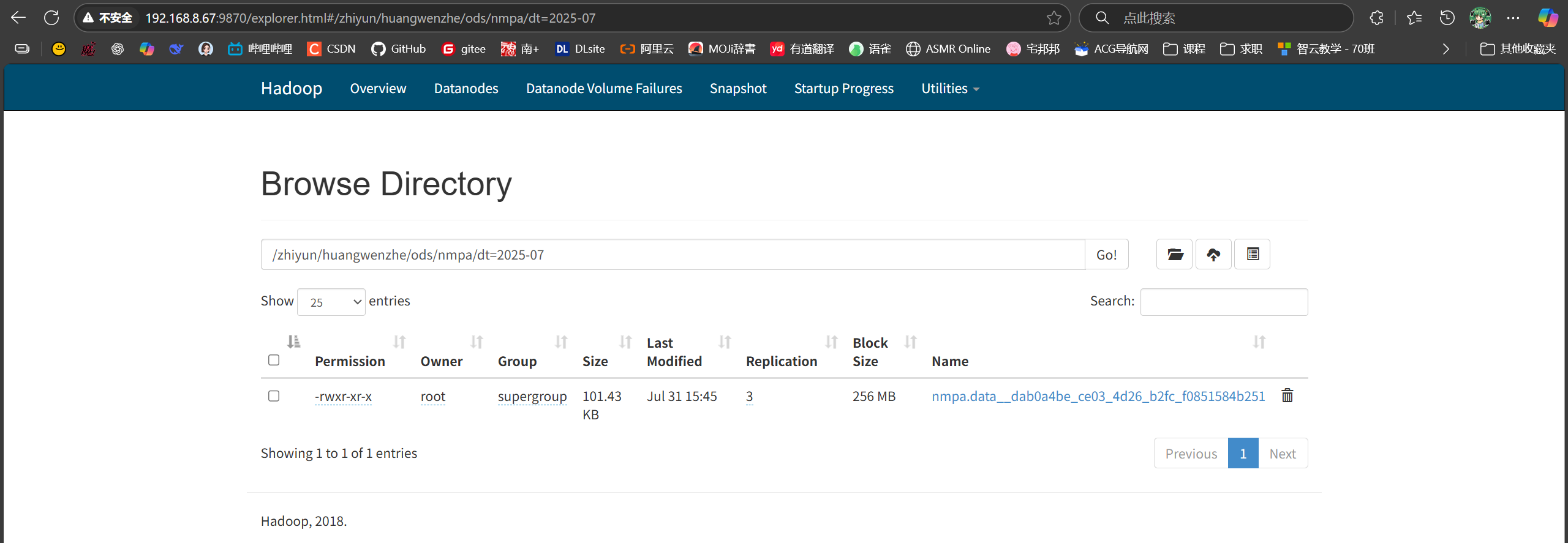

在Browsing HDFS处验证

1 | # 开始抽取 |

在Browsing HDFS处验证

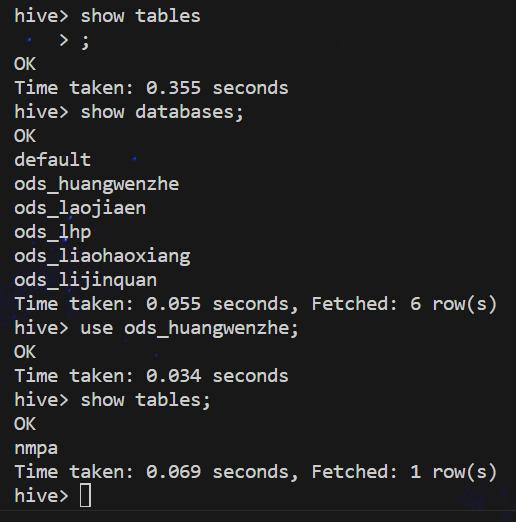

Hive建表

1 | # 终端进入hive |

1 | -- 建立ODS数据库 |

查看表

加载数据到当月分区

1 | load data inpath "/zhiyun/huangwenzhe/tmp/nmpa/*" overwrite into table ods_huangwenzhe.nmpa partition(dt="2025-07"); |

验证数据

1 | select count(1) from ods_huangwenzhe.nmpa; |

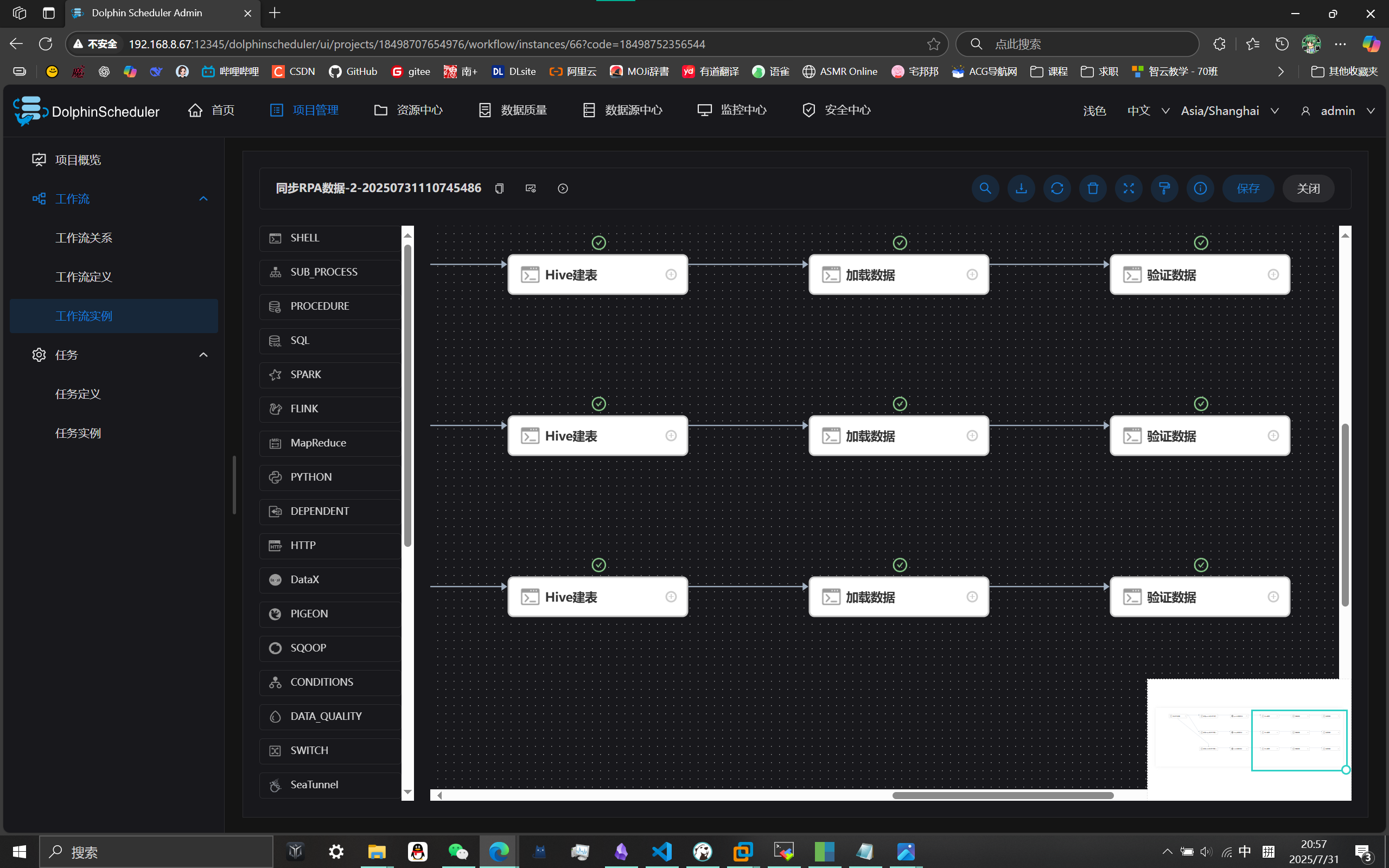

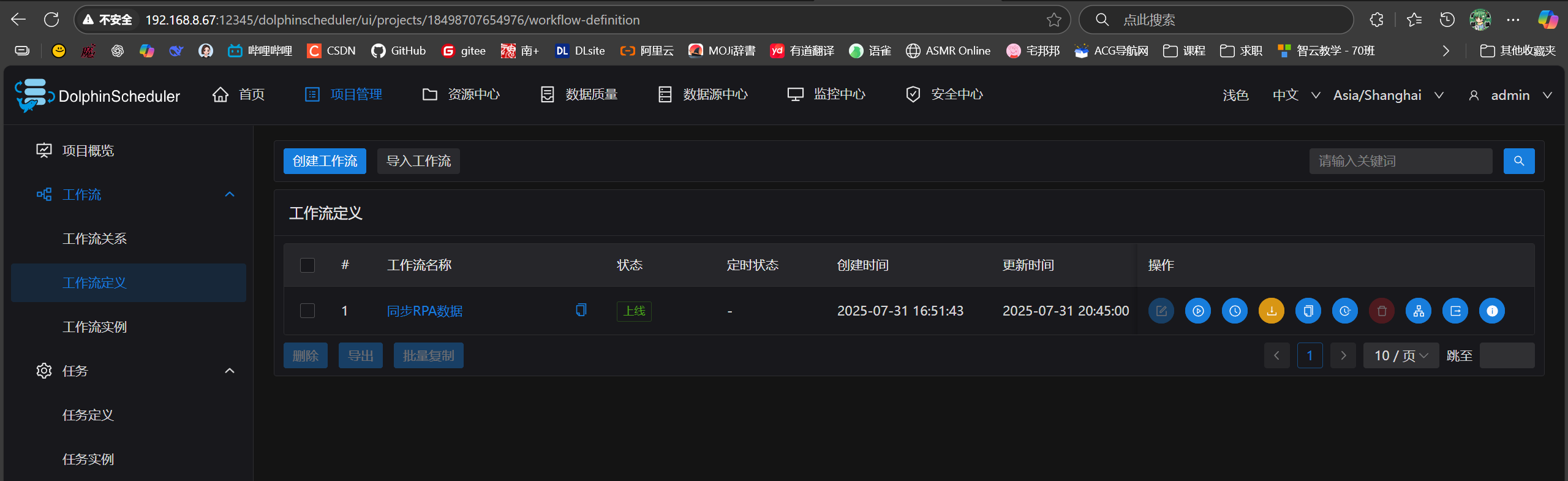

自动化调度

需求:每天凌晨4点自动执行这个流程

调度平台:海豚调度平台

优势:告警机制(任务出错了需要通知);自动重试

用户名/密码:admin / dolphinscheduler123

项目管理-创建项目-点击进入项目-工作流定义-创建工作流

加载数据的shell脚本实现动态按月分区

1 | current_month=$(date +"%Y-%m") # 先定义变量 |

成功运行